W sklepach od wersji 4.3.7. istnieje możliwość dodawania i edycji pliku robots.txt, który pozwala na wykluczenie możliwości indeksowania konkretnych stron przez wybrane roboty wyszukiwarek internetowych, takich jak BingBoot czy GoogleBoot.

Jak dodać lub edytować wpisy do Robots.txt

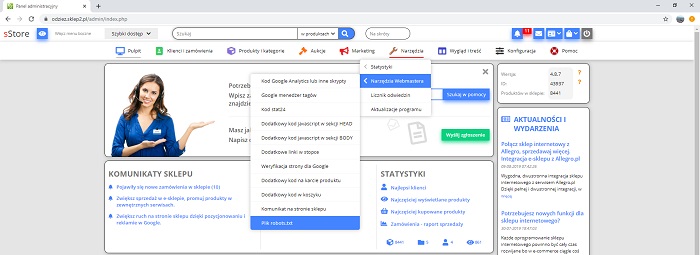

1. W panelu administracyjnym sklepu wskaż kolejno menu Narzędzia >Narzędzia webmastera >Plik Robots.txt.

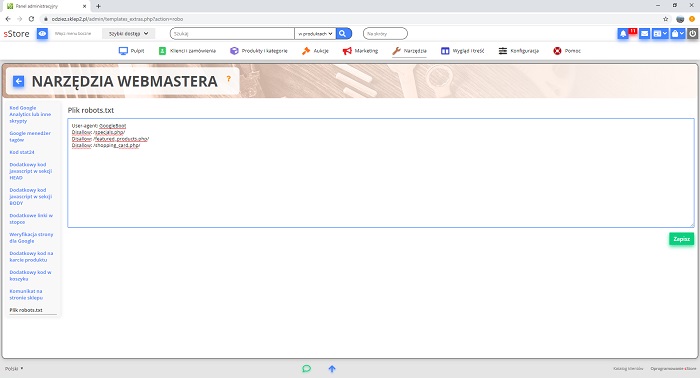

2. W tym oknie możesz wkleić zawartość pliku Robots.txt. Dzięki takiemu rozwiązaniu możesz w szybki i wygodny sposób modyfikować wpisy w tym pliku bezpośrednio z poziomu panelu administracyjnego sklepu, bez konieczności wgrywania pliku od nowa.

Co można wpisać w pliku Robots.txt

W tym pliku należy wpisać informację o tym, którego robota lub robotów dotyczy dane wykluczenie (disallow) lub zezwolenie (allow) służy do tego linijka User-agent:.

na przykład, jeżeli chcesz, aby reguła dotyczyła tylko robota Google wpisz

User-agent: GoobleBoot.

Jeżeli więc chcesz wykluczyć indeksowanie pliku specjals.php przez robota GoogleBoot, wpisz:

User-agent: GoobleBoot

Disallow: /specials.php/

Oczywiście możesz w ramach jednego robota wpisać wiele wykluczeń indeksowania, podając na początku User-agent: GoogleBoot, a poniżej wpisać każde wykluczenie w nowej linijce, na przykład.

User-agent: GoogleBoot

Disallow: /specjals.php/

Disallow: /featured_products.php/

Disallow: /shopping_card.php/